یکی از جذابترین اتفاقات علمی برای من، وقتیست که شاخههای مختلف علم به یکدیگر میرسند و بر یکدیگر تاثیر میگذارند. به همین خاطر همواره علاقهی ویژهای به حوزههای بین رشتهای (interdisciplinary) داشته ام. محض مثال، تلاقی حوزههای مختلف فیزیک با نظریهی اطلاعات، یکی از موضوعات بسیار جذاب است که سابقهی آن به قرن بیستم و کارهای کلاود شانون باز میگردد. محض مثال مفهوم آنتروپی یک مفهوم فیزیکی یا به عبارت دقیقتر ترمودینامیکی است.

ما آنتروپی را به عنوان معیاری از بینظمی میشناسیم. آنتروپی یک ظرف یخ از آنتروپی یک ظرف آب کمتر است. چرا که یخ از کریستالهایی تشکیل شده که مولکولهای آبی درون این شبکهی کریستالی حبس شده است. اما مولکولهای آب درون یک ظرف آب، آزادانه به هر طرف میروند و نسبت به مولکولهای آب درون یخ، بینظمی بیشتری دارند. و باز هم به همین دلیل آنتروپی یک محفظهی حاوی بخار آب باز هم بیشتر است. چرا که این مولکولها آزادانهتر در فضا حرکت میکنند و آنتروپی این ظرف بخار بیشتر است.

اما اجازه دهید آنتروپی را به نظریهی اطلاعات ربط دهیم و ببینیم این دو با هم چه چیزی میسازند. اصلا ببینیم آنتروپی با دانش (knowledge) چه ارتباطی دارد. دانش اطلاعاتیست که بهرهای از قطعیت دارد. حالا فرض کنید ما سه ظرف مختلف داریم. در ظرف اول ما سه توپ سبز داریم. در ظرف دوم دو توپ سبز و یک توپ زرد داریم. در طرف سوم، یک توپ سبز و یک توپ زرد و یک توپ قرمز داریم. اگر بخواهیم آنتروپی این سه ظرف را لحاظ کنیم، ظرف اول، دوم و سوم، به ترتیب کمترین آنتروپی به بیشترین آنتروپی را دارند. چرا که ظرف اول هر سه توپش سبز است و بینظمی یا آنتروپی آن کم است. اما ظرف سوم، سه توپ با سه رنگ متفاوت دارد پس بینظمی یا آنتروپی آن زیاد است. حالا ما میخواهیم چشمانمان را ببندیم و دستمان را وارد هر ظرف کنیم.

در هر حالت، انتظار داریم توپ با کدام رنگ از ظرف خارج شود؟

در مورد ظرف اول ما مطمئنیم که هر توپی خارج کنیم، رنگ سبز خواهد داشت. پس ما دانش قطعی و کاملی نسبت به این ظرف داریم.

در ظرف دوم، ما با احتمال ۶۶/۶۷ درصد، توپ سبز و با احتمال ۳۳/۳۳ درصد توپ زرد را از ظرف خارج خواهیم کرد.

در مورد ظرف سوم، ما با احتمال ۳۳/۳۳ درصد توپ سبز، با احتمال ۳۳/۳۳ درصد توپ زرد و با احتمال ۳۳/۳۳ درصد توپ قرمز از ظرف خارج میکنیم.

پس انگار ظرف اول، بیشترین میزان دانش را به ما میدهد، چرا که ما میدانیم که حتما توپ سبز خواهیم داشت. ظرف دوم هم تا حدی به ما دانش میدهد، اما ظرف سوم کمترین دانش را به ما خواهد داد. پس انگار آنتروپی معنایی مخالف دانش دارد. یا به زبان دیگر، آنتروپی میزان عدم قطعیت یا فقدان دانش را نشان میدهد.

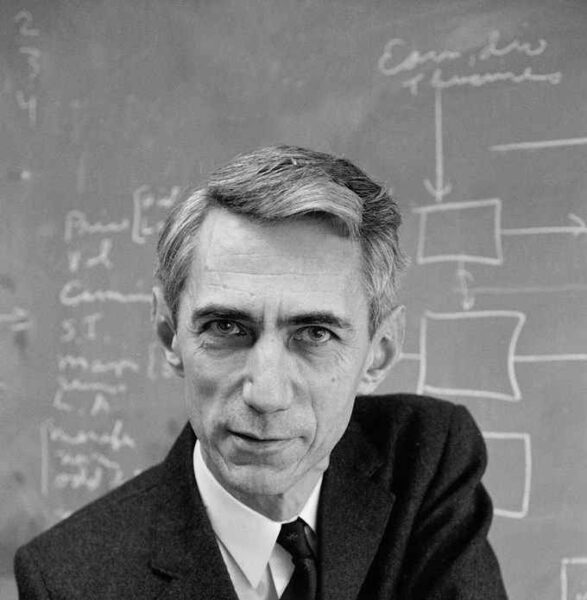

ما در مورد آن سیستم فیزیکی مثال مولکولهای آب نیز با همین فقدان اطلاعات روبرو بودیم. وقتی ما مکان مولکولهای آب و جهت حرکتشان را نمیدانیم، آنتروپی ظرف آب مایع بالاست. اما وقتی از این بابت که مولکولهای آب به شکل کریستالهای یخ در آمدهاند و مکان و جهت حرکت آنها مشخص است، ما اطلاعات زیادی راجع به این سیستم داریم. اما وقتی ما از اطلاعات صحبت میکنیم، منظور متفاوتی از سایر سیستمهای فیزیکی داریم و به همین علت نیاز به تعریف جدیدی از آنتروپی داریم که ریاضیدان آمریکایی کلاود شانون آن را به عنوان آنتروپی شانون (shannon entropy) معرفی کرد که یکی از مفاهیم بسیار مهم در نظریهی اطلاعات است.

– ابا اباد